Algorithmen, die unsere Emotionen beeinflussen

Die zu Grunde liegende Studie ist veröffentlicht und ist hier zugänglich.

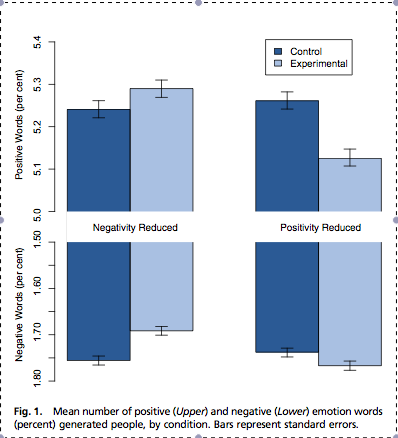

Kurz gefasst, haben Forscher bei englischsprachigen Facebook-Nutzern folgendes gemacht: Sie haben bei Testgruppen den Facebook-Newsfeed manipuliert. Und das folgendermaßen: Bei einer Gruppe wurden positive Posts herausgefiltert und bei den anderen negative. Die emotionale Gewichtung entnahm man einem speziellen Wortverzeichnis. Anschließend wurde untersucht, wie sich die Manipulierung des Newsfeeds auf die Posts der Nutzer auswirkte. Dazu gab es dann auch noch jeweilige Kontrollgruppen. Das Ergebnis war, dass sich ein Zusammenhang feststellen ließ. Kamen in dem manipulierten Newsfeed vermehrt positive Posts vor, so posteten die Nutzer auch vermehrt positiv. Selbiges gilt mit Blick auf die negative Filterung. Und insgesamt stellte man fest, dass die durch die Filterung mit emotionaleren Posts angereicherten Newsfeeds auch mehr Posts der Nutzer generiert. Diese Beeinflussung wurde ohne das Wissen der Nutzer vorgenommen, somit wurden sie unbewusst beeinflusst. Allein der Umstand, dass ein solches Experiment von den Facebook-AGBs anscheinend abgedeckt wird, ist gruselig genug. Weiter zeigt dieses Experiment aber auch, dass man den Einfluss von Algorithmen auf die Gesellschaft nicht unterschätzen darf. Wenn Facebook seinen Newsfeed-Algorithmus ändert, ist das nicht der Untergang des Abendlandes, aber dieser noch harmlose Eingriff lässt auch erahnen, was mit Eingriffen in Direktkommunikation, Suchergebnisse etc. alles möglich wäre.

Dieses Experiment massiven Ausmaßes war so groß, dass selbst die Facebook-Infrastruktur zeitweise zusammenbrach und das ganze in einen zeitweisen Facebook-Ausfall resultierte. Natürlich kann man dem Experiment auch etwas positives abgewinnen, so verweisen die Autoren selbst darauf, dass es einen belegten Zusammenhang zwischen Emotionen und Gesundheit gibt. Es ist wie beim Lügendetektor; diesen pauschal als amoralisches Teufelswerk abzutun, wäre selbstgerecht gegenüber den unschuldig im Gefängnis eine Strafe verbüßenden Justizirrtums-Opfern. So wäre es auch denkbar, dass angesichts der Größe Facebooks mit solchen Änderungen am Algorithmus tatsächlich Leben oder jedenfalls Lebenszeit gerettet werden könnte. Es klingt absurd, ist aber dennoch weniger abwegig, als man vermuten mag. Der Einfluss ist jedoch, wie man der Grafik entnehmen kann, kein gewaltiger.

Wenn man die Skala beachtet stellt man fest: Die maximale Abweichung der Prozentwerte ist “bloß” 0,02% (oben rechts)

Dennoch sollte es einen aufhorchen lassen. Das öffentlich oft als Paradebeispiel zitierte unschmeichelhafte Partybild ist zwar eingängig und leicht verständlich, die implizite Einflussnahme durch intransparente Algorithmen ist hingegen eine eher abstrakte und öffentlich nicht ausreichend präsente Thematik, die meines Erachtens mehr Aufmerksamkeit verdient. So gibt es beispielsweise in der Piratenpartei Forderungen nach gesetzlichen Regulierungen für Algorithmen, die bestimmte Szenarions schlichtweg verbietet.